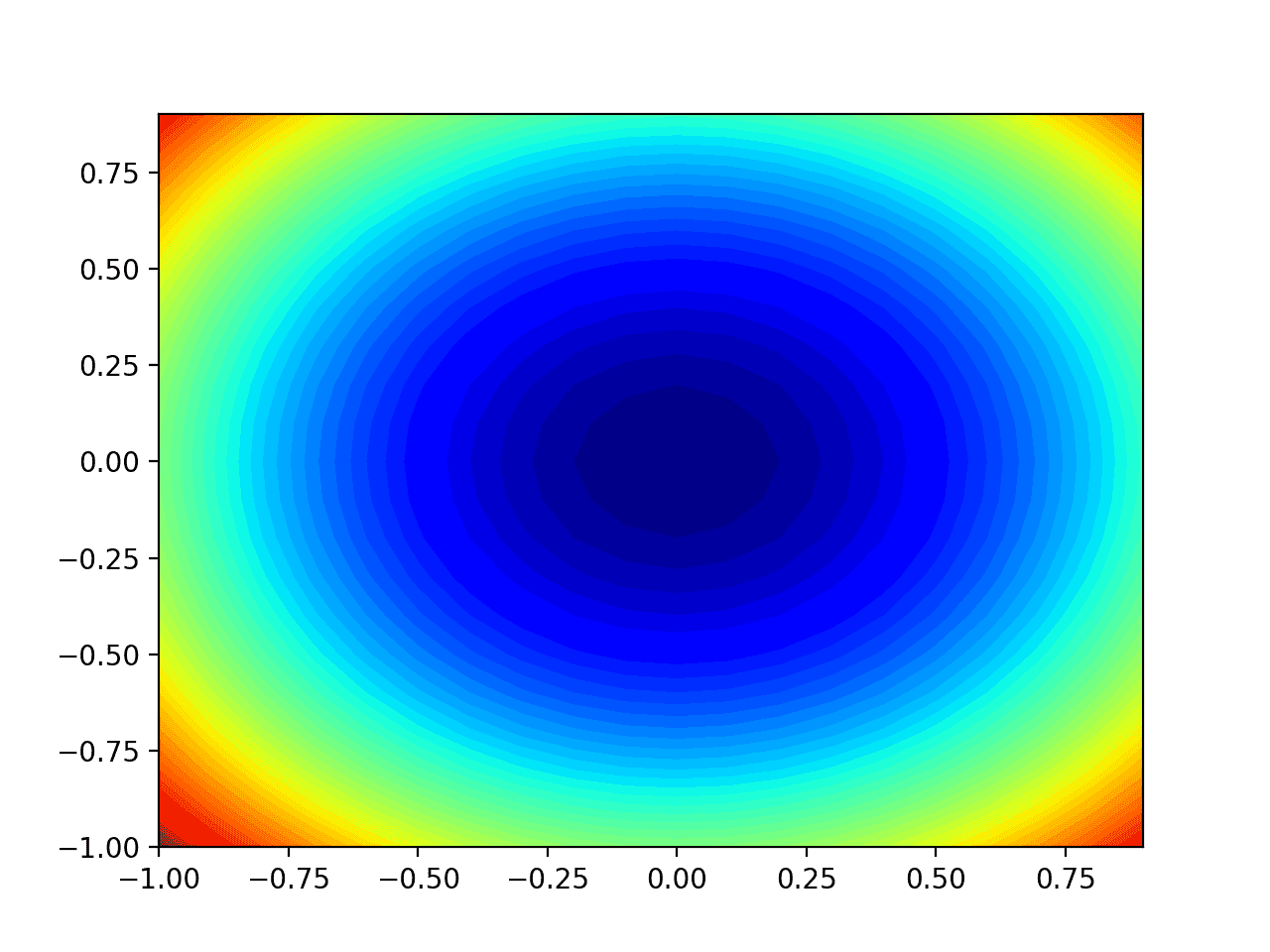

경사하강법은 함수의 최소값을 찾기 위해 목적 함수의 음의 기울기를 따르는 최적화 알고리즘입니다. 경사하강법의 한계는 모든 입력 변수에 대해 단일 단계 크기(학습률)가 사용된다는 것입니다. AdaGrad 및 RMSProp과 같은 경사하강법 확장은 각 입력 변수에 대해 별도의 스텝 크기를 사용하도록 알고리즘을 업데이트하지만 스텝 크기가 매우 작은 값으로 빠르게 줄어들 수 있습니다. 적응형 이동 추정 알고리즘 (Adaptive Movement Estimation algorithm) 또는 […]